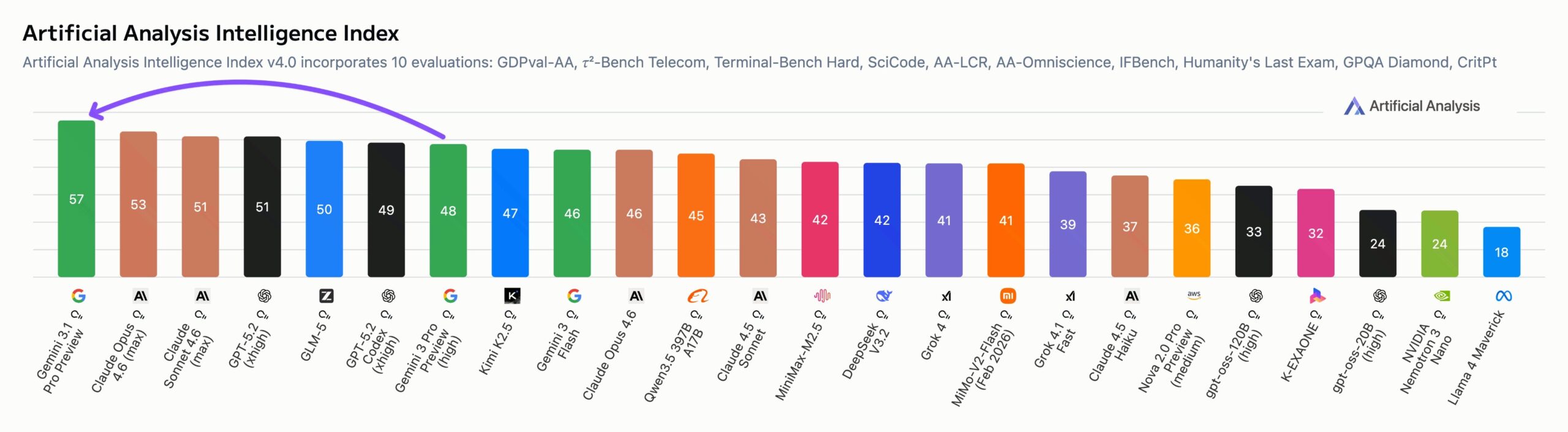

Googles Gemini 3.1 Pro Preview führt den Artificial Analysis Intelligence Index an, vier Punkte vor Anthropics Claude Opus 4.6, und kostet dabei weniger als die Hälfte im Betrieb. Das Modell führt in sechs von zehn Einzelbewertungen, darunter agentenbasiertes Coding, Wissen, wissenschaftliches Denken und Physik. Die Halluzinationsrate sank um 38 Prozentpunkte gegenüber dem anfälligen Vorgänger Gemini 3 Pro. Der Artificial Analysis Intelligence Index fasst zehn verschiedene Benchmarks zu einer Gesamtpunktzahl zusammen.

Die Kosten für den gesamten Indextest lagen bei 892 Dollar, verglichen mit 2304 Dollar für GPT-5.2 und 2486 Dollar für Claude Opus 4.6. Gemini verbrauchte nur 57 Millionen Token, deutlich weniger als GPT-5.2 mit 130 Millionen. Bei realen Agentenaufgaben liegt Gemini 3.1 Pro allerdings weiterhin hinter Claude Sonnet 4.6, Opus 4.6 und GPT-5.2. Open-Source-Modelle wie GLM-5 sind mit 547 Dollar nochmals günstiger.

Benchmark-Ergebnisse sind wie immer nur eine Orientierung für den alltäglichen Nutzen. In unserem internen Fact-Checking-Benchmark schneidet 3.1 Pro viel schlechter ab als Opus 4.6 oder GPT-5.2, weil das Modell bei ersten Tests nur rund ein Viertel der Aussagen prüft; noch weniger als das in dieser Hinsicht schon schwache Gemini 3 Pro.